Terminamos 2023 com mais dúvidas e desafios, que respostas e soluções no âmbito da Soberania Digital.

Há que se responsabilizar as plataformas: chegamos ao fim de 2023 e o debate sobre a regulação das plataformas esteve em voga durante todo ano. Para quem achava que seu protagonismo se limitava ao período eleitoral, 2023 veio para mostrar que as gigantescas big techs (pleonasmo intencional) seguem fugindo de suas responsabilidades, e por vezes – como no debate sobre o Projeto de Lei 2630 – interferindo como agentes políticos, seja ao entregar mais conteúdos favoráveis e menos publicações contrárias – como o X, antigo Twitter – ou de forma ainda mais clara ao enviar mensagens – como o Telegram – ou deixando mensagens na home – como o Google. Como apresentaram os professores Vitor Blotta e Tatiana Stroppa, durante 46º Congresso Brasileiro de Ciências da Comunicação da Intercom – Sociedade Brasileira de Estudos Interdisciplinares da Comunicação, que ocorreu em setembro deste ano em Belo Horizonte (MG), estas empresas se apropriam do conceito de liberdade de expressão – utilizadas em campanhas midiáticas de grupos sociais e empresas de tecnologia no atual cenário político brasileiro – ao mesmo tempo em fazem uso da estratégia que se tem convencionado denominar flooding, ou “censura por inundação”.

Em resposta, os precedentes legislativos e jurídicos avançaram. A União Europeia (UE) aprovou, ainda em 2022, os marcos regulatórios Digital Services Act, para um ambiente digital seguro, no qual os direitos dos usuários sejam respeitados, e o Digital Market Act [1], que trata de direito antitruste quanto para os mercados digitais, buscando regular o uso e a atuação das big techs com normas que vão desde ações voltados ao consumo online de produtos, serviços e conteúdos ilegais, até a utilização de algoritmos na manipulação e impulsionamento de conteúdos desinformativos. Ainda no campo da legislação, está em discussão no Conselho da Europa o AI Act, marco regulatório sobre o uso da Inteligência Artificial, tendo como princípios ambientes seguros, transparentes, rastreáveis, não-discriminatórios e sustentáveis.

Por descumprir essas normas, em maio deste ano a Meta, empresa dona das redes sociais Facebook e Instagram, e do mensageiro Whatsapp, foi condenada a pagar uma multa de 1,2 bilhão de euros, o equivalente a R$ 6,4 bilhões, por transferir dados dos usuários para os Estados Unidos. Mais recentemente, em novembro, o órgão responsável pela regulamentação da concorrência no Reino Unido realizou um acordo com a Amazon e a Meta. No documento, as big techs se comprometem com disputas mais “justas” em suas plataformas de vendas online.

Nos Estados Unidos, a Meta está sendo processada por 42 estados norte-americanos acusada de utilizar suas plataformas de mídia social para explorar jovens para obter lucro e ofertar conteúdos prejudiciais. Durante o processo, veio a público, a partir de e-mails internos da Meta, que Mark Zuckerberg, dono da empresa, vetou iniciativas para proteger a saúde mental de adolescentes usuários das plataformas de mídia social. O veto foi sobre o retirar filtros de “beleza”, devido a sua influência sobre a auto-estima dos jovens.

O processo teve sua primeira vitória – para a sociedade – depois que a juíza distrital Yvonne Gonzalez Rogers, em Oakland, na Califórnia, rejeitou um pedido das empresas para derrubar os processos, com base na Primeira Emenda da Constituição estadunidense, onde seriam “imunes à responsabilidade de conteúdo criado e publicado por usuários”. Na mesma linha, a UE solicitou ao TikTok e o YouTube que listassem medidas para proteger crianças e adolescentes de conteúdo ilegal e prejudicial nas plataformas.

Em março deste ano, durante audiência pública realizada no Supremo Tribunal Federal (STF) para discutir pontos do Marco Civil da Internet, representantes da Meta (dona do Facebook, Instagram e WhatsApp) e do Google, foram contrários a aumentar a responsabilidade civil das plataformas. Na ocasião, o advogado da Google Brasil, Guilherme Cardoso Sanchez, defendeu que a responsabilização das plataformas “levaria a um dever genérico de monitoramento de todo o conteúdo produzido pelas pessoas” criando “uma pressão para remover qualquer discurso minimamente controverso”.

O ano de 2024 está aí, e com eles as eleições municipais. Os desafios seguem enormes e especialistas apontam em especial o risco do uso da Inteligência Artificial no próximo período para a disseminação de desinformação. A qui na América Latina, nos últimos dias de campanha eleitoral argentina, os então candidatos, Sergio Massa (coligação Unión por la Patria) e Javier Milei (coligação La Libertad Avanza), utilizaram de forma intensa a IA, principalmente para criação de publicidades negativas aos adversários. Em reportagem do jornal O Estado de S.Paulo, os principais candidatos à Prefeitura de São Paulo sinalizaram que irão usar a tecnologia em suas estratégias de comunicação. Seu uso está na ordem do dia da justiça eleitoral brasileira, que debate o tema no Tribunal Superior Eleitoral (TSE).

Se antecipando à discussão e como forma de fortalecer a auto regulação, modelo hoje vigente no país, no qual as próprias empresas criam suas políticas de uso, a Meta anunciou no mês passado sua nova política para anúncios sobre questões sociais, políticas e eleições que sejam criados ou alterados digitalmente. Se a propaganda veicular imagem ou áudio realistas, mas que tenham sido criados digitalmente, os anunciantes deverão informar o público. Também em novembro, a empresa lançou a campanha “Sua segurança é coisa séria” [2] para combater golpes. A iniciativa dispõem de vídeos e programetes de rádio (disponibilizados em mais de 2 mil estações de rádio em todo o país) sobre segurança nas plataformas do Facebook e do Instagram.

De acordo com TIC Domicílios 2023 [3], mais famílias possuem celular em relação à televisão, embora a diferença seja ínfima (94% das famílias com TV, diante de 95% com smartphones), é a primeira vez na história que a televisão é “desbancada”. Em 2022, 95% dos lares brasileiros tinham televisão, frente 93% que possuíam aparelhos celulares.

Mas o Brasil está longe de estar conectado de maneira democrática, enquanto 92% da classe A se conecta à banda larga, 84% da classe B, 74% da C e apenas 59% das classes DE têm acesso a esta conectividade.

O relatório Compromisso com a Democracia – Diagnósticos e recomendações nº 10” [4] do InternetLab, centro independente de pesquisa interdisciplinar, trata da integridade eleitoral e o Estado Democrático de Direito nas políticas de plataformas digitais. De acordo com o documento: “As plataformas digitais (ou provedores de aplicação de internet) são verdadeiras infraestruturas do debate público”. Durante as eleições de 2022, o centro mapeou e categorizou políticas existentes de moderação de conteúdo e identificou as plataformas que já possuíam algum tipo de previsão sobre integridade eleitoral.

O levantamento aponta que Twitter (X), Youtube, Facebook, TikTok, Kwai e Linkedin proibiam conteúdos enganosos sobre local e métodos de votação, participação de candidatos em uma eleição e registro de eleitores, entre outras como sinalizar publicidades eleitorais, no caso das redes da Meta, por exemplo. Enquanto o Telegram não tinha políticas específicas para combater a desinformação, o whatsapp inseriu soluções com o banimento de mensagens em massa e limites mais rígidos para mensagens virais, acompanhadas de etiquetas de encaminhamento. O documento ainda apresenta que:

“apesar da existência de uma ou outra categoria específica para processos cívicos e, em especial, para as eleições, a maioria das publicações que podem representar ameaças ao debate democrático ou aos direitos humanos acabam sendo regulados por moderadores de conteúdo através de parâmetros mínimos estabelecidos pelas plataformas para balizar outros comportamentos. […] Todavia, estas regras mais gerais não abordam todos os comportamentos que podem causar danos a processos eleitorais ou ao Estado Democrático de Direito.” (INTERNETLAB, 2023, p.15)

Para o Centro é imprescindível que as plataformas estabeleçam regras internas específicas sobre processos cívicos e democráticos. O Internetlab também realizou o estudo “Os Vetores da 2022/2023 – Comunicação Política em Aplicativos de Mensagens” [5] que identificou que 99,3% do público utilizava o whatsapp como principal aplicativo de mensageria. O segundo colocado, as mensagens do instagram, era utilizado por 67% do grupo. Também sendo o utilizado com maior frequência (96%, frente a 69% do instagram). Com espaço de recepção de informação, “existe uma grande parcela de pessoas que se mostram interessadas em estar em grupos mesmo sem interação, buscando absorver informações e acompanhar acontecimentos”, 3 a cada 10 pessoas estão sendo expostas a mensagens em muitos grupos sem que façam algum tipo de interação e 2 a cada 10 pessoas ou deixam o grupo, ou interagem.

Quatro a cada 10 pessoas interagem em muitos grupos de acordo com a função esperada pelos aplicativos. E, no que talvez tenha sido a eleição mais polarizada dos últimos anos, 52% relatou estar evitando falar sobre política nos grupos de famílias e 28% alegaram só falar sobre o assunto em grupos nos quais as pessoas compartilhem de suas crenças. Apenas 35% clica em links enviados nos grupos, o principal motivo é o medo de cair em golpes ou ter seus dados roubados. O estudo também apresenta outros desafios, 38% admite ter repassado notícias sem conferir a fonte e 44% que, se a pessoa que encaminhou o conteúdo é de confiança, tende a acreditar que se trata de uma informação verídica.

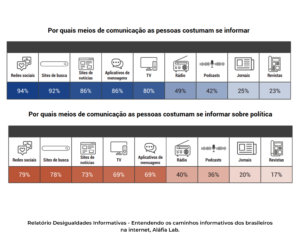

O relatório Desigualdades Informativas – Entendendo os caminhos informativos dos brasileiros na internet [5], do Aláfia Lab, laboratório de pesquisa que se concentra nas áreas que entrelaçam internet, política e sociedade, mostra que as redes sociais são as fontes de informação mais usadas em todas as faixas etárias (94%), mas o tipo de rede mais usada em cada fase da vida varia bastante. O Instagram aparece como fonte prioritária de informação entre os mais jovens e o do Facebook faz o caminho contrário. O WhatsApp é a fonte de informação usada com mais estabilidade em todos os grupos analisados: “a proximidade da fonte de informação é um fator preponderante, com 75,3% das pessoas obtendo informações exclusivamente ou principalmente por meio de conversas individuais.”

O estudo mostra que “as redes sociais solidificaram-se como canais para o acesso à informação e desempenham um papel crucial como fonte prioritária no consumo de conteúdo informativo”.

Ainda que o debate pela lógica de funcionamento das plataformas tenda sempre a problematizar o comportamento de seus algoritmos, e esse debate e suas mais diversas vertentes – como o racismo algorítmico e o preconceito linguístico, por exemplo – de fato sejam centrais ao debate das mudanças tecnológicas e do futuro de nossa sociedade, este artigo traz a tona outro aspecto fundamental fundamental no debate do capitalismo de plataforma: o papel das empresas, das big techs, na moderação e controle de conteúdos violentos, racistas, preconceituosos, misóginos, fascistas e ou mesmo que possam provocar prejuízos financeiros aos cidadãos.

Se a tecnologia falha, de quem é a culpa?

As diretrizes da Meta [7], mas especificamente no documento dos Padrões de comunidade, a empresa diz que o “comprometimento com a expressão é uma prioridade” e que quando este é limitado é com base em um ou mais dos valores de autenticidade, segurança, privacidade e dignidade. Sendo que, em segurança, justifica-se: “Removemos conteúdo que possa contribuir para o risco de danos à segurança física das pessoas. Conteúdo com ameaças pode intimidar, excluir ou silenciar pessoas, e isso não é permitido no Facebook.” E em dignidade: “Acreditamos que todas as pessoas são iguais no que diz respeito à dignidade e aos direitos. Esperamos que as pessoas respeitem a dignidade alheia e não assediem ou difamem terceiros.”.

Violam portanto os padrões de comunidade da plataforma: Violência e incitação; Organizações e indivíduos perigosos; Coordenação de danos e incitação ao crime; Produtos e serviços restritos; Fraude e dolo; Suicídio e automutilação; Exploração sexual, abuso ou nudez infantil; Exploração sexual de adultos; Bullying e assédio; Exploração humana; Violações de privacidade; Discurso de ódio; Conteúdo violento e explícito; Nudez e atividade sexual de adultos; Proposta de cunho sexual; Integridade da conta e identidade autêntica; Spam; Segurança cibernética; Comportamento não autêntico; Desinformação; Transformação em memorial; Propriedade intelectual; com proteção adicional de menores de idade.

Devemos lembrar que mesmos esses avanços mínimos “ofertados” pela big techs não vieram de graça. Depois de diversas denúncias de mau uso de dados de usuários e distribuição de notícias falsas em massa, principalmente nas eleições presidenciais estadunidenses de 2016, as plataformas de mídias sociais, em especial o Facebook, foram obrigadas a mudar diretrizes e termos de uso.

Se elas são a única “Lei” que rege os padrões da plataforma, de quem é a responsabilidade quando uma publicação que claramente viola a mesma é postada, ficando dias no ar até que a mesma a tire?

No Brasil tivemos uma experiência de consequências concretas gravíssimas no dia 8 de janeiro de 2023, na tentativa de golpe de estado que ocorreu em Brasília, onde milhares de pessoas invadiram as sedes dos poderes. As mobilizações tiveram as redes sociais e aplicativos de mensageria como principais formas de organização do movimento golpista.

O Facebook aprovou uma série de anúncios que promoviam violência política no Brasil, dias depois dos ataques às sedes dos Três Poderes em Brasília, como denunciou a Global Witness. A organização utilizou contas falsas para enviar 16 anúncios falsos para a plataforma, 14 foram aprovados para publicação. Os anúncios tinham frases como: “Precisamos desenterrar todos os ratos que se apoderaram do poder e atirar neles” e “Morte aos filhos dos eleitores de Lula.”

Antes dos atos antidemocráticos acontecerem, a Agência Pública identificou ao menos outros 65 anúncios publicados no Facebook e Instagram por bolsonaristas que divulgavam protestos antidemocráticos e defendiam um golpe para impedir a posse do presidente eleito, Luiz Inácio Lula da Silva (PT). Quando a denúncia foi publicada, as publicações já haviam sido vistas pelo menos 414 mil vezes do início de novembro de 2022 até janeiro 2023.

A tentativa de golpe foi alvo de uma CPMI e os vândalos detidos estão sendo julgados pelo STF. As investigações, no entanto, mencionam empresários financiadores e figuras políticas, como responsáveis pelo episódio. Mas as plataformas, mais uma vez, saem ilesas.

É claro que os desafios, principalmente para o próximo ano, são imensos. Mas uma coisa é fundamental: há que se responsabilizar as plataformas e suas empresas em termos jurídicos, aplicando à sua atuação princípios como dever de cuidado, responsabilidade objetiva, trabalho para evitar riscos sistêmicos e transparência à academia, aos governos e à sociedade civil. Sem isso, as plataformas digitais continuarão em sua atual descendente de legitimidade.

Notas

[1] Legislações disponíveis em: https://digital-strategy.ec.europa.eu/pt/policies/digital-services-act-package

[2] Disponível em https://about.fb.com/br/news/2023/11/sua-seguranca-e-coisa-seria-meta-lanca-campanha-educativa-de-seguranca-para-facebook-e-instagram/

[3] Disponível em https://cetic.br/pt/tics/domicilios/2023/domicilios/A/

[4] Disponível em https://internetlab.org.br/wp-content/uploads/2023/09/InternetLab-Integridade-eleitoral-e-plataformas.pdf

[5] Disponível em https://internetlab.org.br/wp-content/uploads/2023/11/Investigando-os-vetores-de-disseminacao-de-conteudo-eleitoral_PT_versao-09.pdf

[6] Disponível em https://alafialab.org/wp-content/uploads/2023/10/Relatorio-desigualdades-informativas-Alafiala-2023_compressed.pdf

[7] Disponível em https://www.facebook.com/policies_center/

***

Larissa Gould é jornalista no Ministério do Desenvolvimento Social, Família e Combate à Fome, membra do Centro de Estudos da Mídia Alternativa Barão de Itararé, mestranda no PPGCOM/ECA-USP e pesquisadora do Grupo de Estudos Jornalismo, Direito e Liberdade (JDL), vinculado à ECA e IEA-USP.